Что в выпуске?

🌇 Привет, это твой ночной ИИ-дайджест II февраля

Вот что я тебе сегодня приготовил и зачем тебе тратить 7 минут чтобы это прочитать

🎬 Новая модель Kling 3.0 решила проблему индустрии

🍌 Google Cloud AI сделали ещё один “бананан”, теперь для учёных

📱 ByteDance испугался Seedance 2.0 и выключил пару главных фич

🧑🏿💻FOMO интервью , которое стоит посмотреть каждому

😱Нам 3.14 пошел в YouTube: посмотрите наш пилот

И ещё +11 новостей - быстрых, как ИИ: Cerebras поднял $1B при оценке $23.1B, ElevenLabs поднял $500M при оценке $11B, Gemini у Google - 750M+ MAU и $175-185B капзатрат в 2026, METR меряет GPT-5.2 high на 6.6 часа time-horizon, Lotus Health поднял $35M на AI-первичку по США, Alexa+ бесплатно для Prime и $19.99/мес для остальных, Roblox Cube дал 4D generation интерактивных объектов, Perplexity Deep Research Advanced для Max, Perplexity Model Council гоняет запрос через 3 модели, Mistral Voxtral Transcribe 2 с open-weights Realtime на 13 языков, Meta делает отдельное приложение Vibes для AI-видео.

⚠️ ДИСКЛЕЙМЕР

ПРОЧТЕНИЕ ЭТОГО ДАЙДЖЕСТА РЕЗКО ПОВЫШАЕТ УРОВЕНЬ FOMO, ИДЕАЛЬНО ДОПОЛНЯЕТ УТРЕННИЙ КОФЕ И КАТЕГОРИЧЕСКИ ПРОТИВОПОКАЗАНО ПЕРЕД МЕДИТАЦИЕЙ И СНОМ — ВОЗМОЖНЫ ПРИСТУПЫ ВНЕЗАПНЫХ ИНСАЙТОВ И НЕУДЕРЖИМОЕ ЖЕЛАНИЕ СРОЧНО ЗАПИЛИТЬ СВОЙ СТАРТАП.

ПОГНАЛИ!

Nano Banana

Представь: ты написал хороший метод, но картинка в разделе Method - это боль. Ты сидишь в Figma/PowerPoint, двигаешь стрелочки, выравниваешь подписи, потом ещё получаешь коммент “рисунок нечитаемый”. И так по кругу.

Peking University + Google Cloud AI принесли PaperBanana и сказали: давай это будет делать не аспирант в 2 ночи, а пачка агентов - один ищет референсы, второй раскладывает смысл по блокам, третий приводит к академическому стилю, четвёртый рендерит, пятый придирается и заставляет переделывать. Это не “генератор картинок”. Это автоматизация самого мерзкого этапа научной работы: упаковки идеи в фигуру.

Фактура:

Кто: команда Peking University и Google Cloud AI Research.

Что: PaperBanana - система из 5 AI-агентов: retrieval (ищет примеры), planning (планирует структуру), styling (подгоняет стиль), rendering (рисует), critique (критикует и гонит на доработку).

Бенчмарк: PaperBananaBench - 292 кейса методологических диаграмм из NeurIPS 2025.

Результаты: в сравнении с базовыми подходами у них заявлены +37% по “conciseness” и почти +13% по “readability” на этом наборе.

“Полировка” чужих рисунков: PaperBanana берёт человеческую фигуру и улучшает, и в сравнениях по эстетике побеждает оригинал в 56% случаев.

Плюс: они показывают, что система умеет не только диаграммы, но и статистические графики.

И что?

Изюминка - они стандартизируют вкус и упаковку науки. Когда у тебя появляется агент, который знает “как выглядит нормальная диаграмма NeurIPS”, оформление становится полу-автоматическим стандартом. И это ускоряет не только рисование, а весь цикл “идея -> понятная фигура -> публикация”. Параллельно OpenAI тащит Prism как LaTeX-рабочее место, и вместе это выглядит как сборка “исследовательского конвейера”, где текст, формулы и фигуры делаются внутри одной связки инструментов.

Нам 3.14здец:

Аспирантам и ресерч-инженерам, которые были “человеком для стрелочек”, - 7/10 - потому что ценность “аккуратно нарисовать метод” утекает в кнопку. Что делать:

Собирать свои “домашние стандарты фигур”: шаблоны, палитры, типы блоков - и гнать через такие системы единым стилем.

Проверка смысла руками: агент может сделать красиво и ошибиться в логике, поэтому нужен чек-лист “что фигура утверждает” перед отправкой в статью.

Если ты делаешь инструменты для R&D - встраивать генерацию фигур прямо в пайплайн: из описания метода/кода в диаграмму автоматически.

🇨🇳

Kling

Представь: ты делаешь серию роликов с одним героем. На первом кадре он норм, на втором у него другое лицо, на третьем другая куртка, на четвёртом вообще другой человек. Ты тратишь время не на идею, а на попытку удержать идентичность.

Kling 3.0 пытается закрыть именно эту боль: ты приносишь референс и говоришь “вот этот герой, вот эта сцена, держи это через шоты”. Плюс туда же они пристраивают звук: несколько персонажей, диалоги и клон голоса внутри того же контура.

Фактура:

Кто: Kling - AI-видео продукт Kuaishou (крупная китайская платформа коротких видео).

Что: Kling 3.0 - единая мультимодальная модель: текст в видео, картинка в видео, плюс нативный звук.

Multi-Shot: режим, который собирает ролик из нескольких планов и сам предлагает ракурсы камеры.

“Anchors” - якоря: референс-картинка или референс-видео сохраняются как опора, чтобы фиксировать внешность и детали персонажа/сцены между планами.

Нативное аудио: генерация речи и диалогов, несколько персонажей, расширенные языки; заявлен клон голоса.

Длина: нативная поддержка 15 секунд на клип.

Доступ: сначала Ultra-подписка, затем расширение доступа в ближайшую неделю.

И что?

Это сдвиг от “сделай один красивый клип” к “веди персонажа через серию”. Как только у тебя есть якорь, ты начинаешь собирать библиотеку героев, локаций и предметов, и дальше видео превращается в производственную операцию: один и тот же герой говорит на разных языках, в разных сценах, в разных версиях под рынки. В рекламных командах и контент-студиях это меняет KPI: важнее становится не монтаж, а управление “пулами якорей” и сценарными вариациями.

🚨Нам 3.14здец:

Актёрам-озвучкам и небольшим студиям дубляжа - 9/10 - потому что “голос как сервис” начинает цепляться прямо к генерации видео, без отдельного пайплайна. Что делать:

Зафиксировать контрактами право на голос: где можно, где нельзя, какие сроки и какие носители.

Делать “пакеты голосов” для брендов и персонажей: один голос - много языков - одна манера.

В студиях контента - завести реестр якорей: кто герой, какие допустимые вариации, что запрещено менять.

В маркетинге - перейти к сериализации: один герой, много коротких эпизодов, меньше разовых “кампаний”.

нам 3.14здец на YouTube

Nano Banana

Пилот «нам 3.14здец» про большой сдвиг, который уже идет: подписки на AI, дефицит вычислений, энергетика дата-центров, и почему бизнесу придется внедрять нейросети даже через силу.

В выпуске:

• «Преемник» Альтмана и идея доверить компанию нейросети

• AGI «в этом году» и почему это звучит слишком уверенно

• Почему ChatGPT соглашается с тобой и при чем тут продуктовый дизайн

• ARC / ARC-2 и эффект правильной настройки

• Дата-центры, электричество, охлаждение и батареи на натрии

• AI как новая статья расходов и сегментация на бытовое и профессиональное

• Как внедрять AI в процессы малого бизнеса без религиозного фанатизма

• Автоматизация поддержки, скорости реакции и «вайб-кодинг»

• Кодинг и сокращения: джунам придется взрослеть быстрее

• Куда едет рынок труда и почему «Черное зеркало» больше не выглядит фантастикой

Ссылка на YouTube в первом комментарии.

Лайк - Шер -> Поможет

Мое почтение

🇨🇳

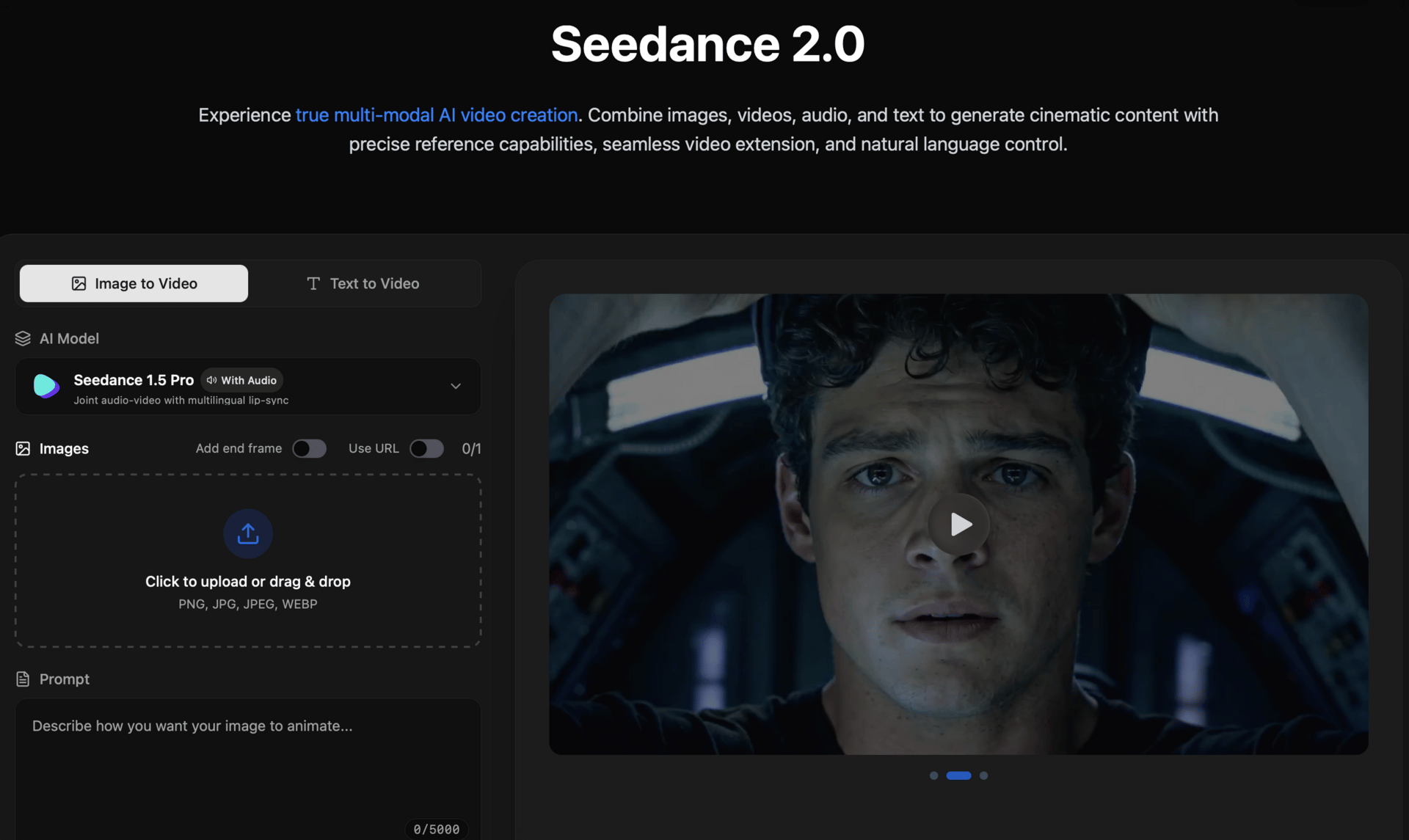

Seedance

Представь: ты делаешь ролик, где герой говорит, дерется, камера прыгает по планам, а звук должен попадать в губы и быть в темпе сцены. В большинстве видео-моделей это разваливается на 3 части: видео отдельно, звук отдельно, синхра отдельно, и ты потом это склеиваешь как взрослый человек, который зачем-то выбрал страдание.

Видеогенерация упиралась в бытовую штуку: ролик без звука и без стабильной личности героя годится только для демонстрации. Seedance 2.0 пытается закрыть это в одном месте - картинка, движение, озвучка и синхронизация. Когда платформа уровня ByteDance кладёт такой инструмент внутрь Jimeng, производство контента превращается в настройку и масштабирование, а не в ручной продакшн.

ByteDance выкатили Seedance 2.0 в бете на Jimeng и показали штуку, которая выглядит как “готовый ролик”, а не красивый немой фрагмент. И изюминка тут даже не “кинематографично”. Изюминка - синхрон звука и управление идентичностью. Настолько, что они уже начали откатывать опасные функции.

Фактура:

Кто: ByteDance (владелец TikTok) запустил Seedance 2.0 в бете на своей платформе Jimeng AI.

Входы: по тестам и описаниям гуляет мультимодальность - текст, картинка, аудио и видео-референсы.

Выход: 15 секунд, 2K, плюс нативная генерация аудио, которое идёт синхронно со сценой.

Доступ: пока это сидит внутри экосистемы ByteDance через Jimeng, а не как “всем API завтра”.

Параллельно: всплывает Seedream 5.0 (их модель для картинок) в превью у части сторонних приложений.

Самый сочный момент: TechNode пишет, что ByteDance уже приостановил фичу Seedance 2.0, которая связывала фото лица с “персональным голосом”, из-за рисков.

Контекст гонки: это выходит почти сразу после Kling 3.0 от Kuaishou - китайские лаборатории явно давят на видео как на стратегический продукт.

И что?

Видеогенерация упиралась в одну бытовую штуку: ролик без звука и без стабильной личности героя - это демка, а ролик со звуком, синхрой и повторяемым персонажем - это уже производственный формат. Как только платформа типа ByteDance кладёт это внутрь своего “контент-завода”, рекламный и UGC-контент начинает делаться не командами, а настройками. И самое важное: раз они уже откатывают фичи вокруг личности (лицо -> голос), значит, следующий фронт войны - не качество картинки, а правила по идентичности и правам.

Нам 3.14здец:

Командам перформанс-маркетинга и креатив-студиям “100 роликов в неделю” - 9/10 - потому что планка “видео сразу с озвучкой” станет базовой, а заказчик начнёт считать стоимость в секундах, как трафик.

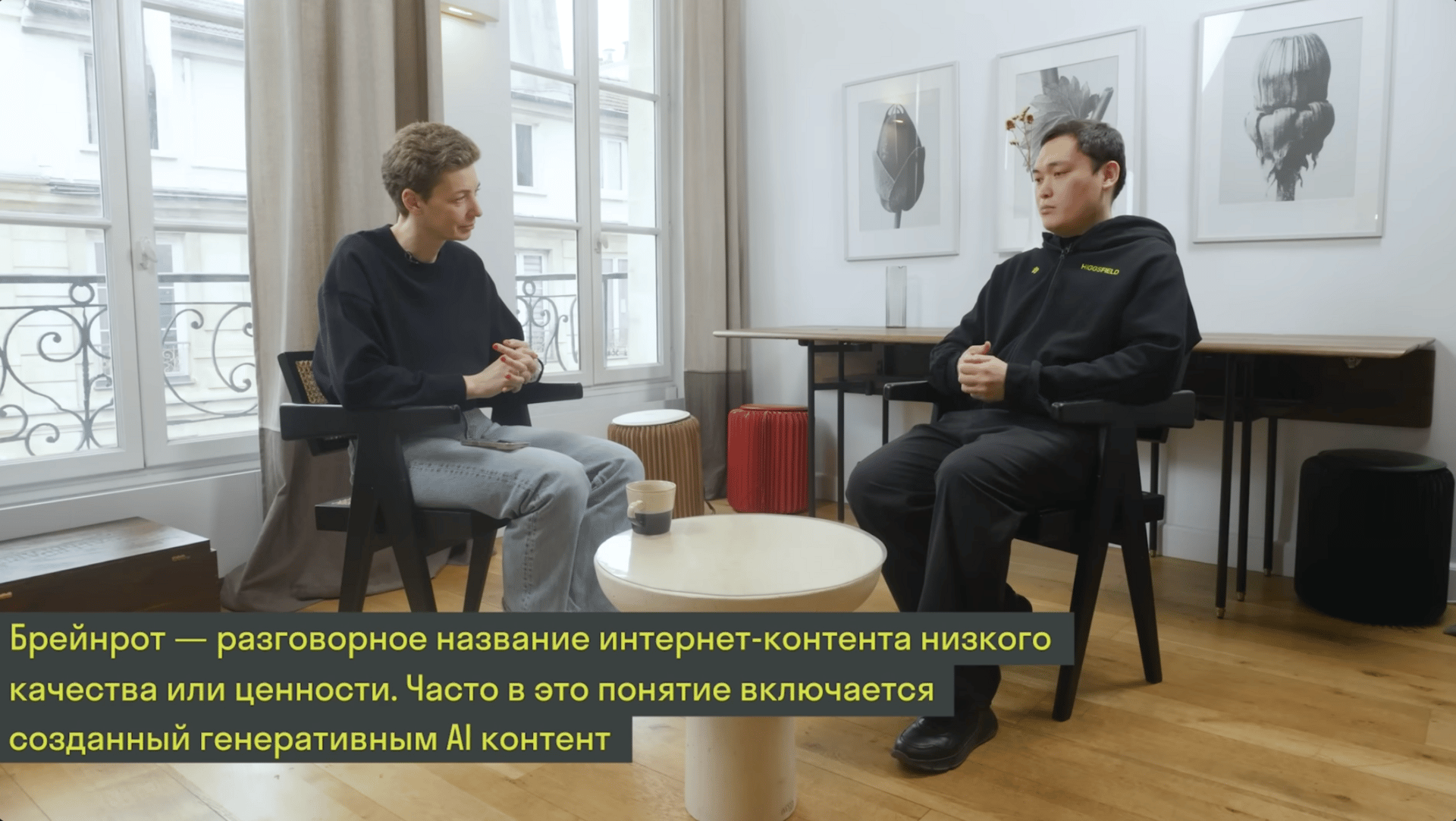

FOMO интервью

Nano Banana

Если вам по жизни мало FOMO и вы хотите получить контрастный душ из FOMO за 2 часа, включите новое интервью у Осетинской, и ваша жизнь станет хуже. Такая концентрация FOMO может вас прикончить. Но всё, что вас не убивает, делает сильнее.

Это, пожалуй, лучшее интервью Осетинской Elizaveta Osetinskaya по актуальности и эксклюзивности за долгое время. Ерзат Дулат для меня открытие этого года. В некоторых моментах я там реально чувствовал себя тараканом или хомяком, который бегает по колесу, думая, что “занят делом”, пока другие за два года делают единорога.

Дальше 10 тезисов, которые я вынес. Это пересказ, не истина в последней инстанции.

1. Скорость сейчас единственный moat. Не “бренд”, не “партнерки”, не “сетевые эффекты”. В ИИ всё меняется каждую неделю. Твоя защита это насколько быстро ты выпускаешь продукт и меняешь его.

2. Низковисящие фрукты. Гиганты строят огромные универсальные модели “на всё”, но часто не дают людям контроля. А бизнес лежит в том, что гигантам скучно или долго делать: дать пользователям контроль над камерой, персонажами, сценой, а не просто “рандом по промту”.

3. Культурный код важнее бюджета. Higgsfield почти не тратит на рекламу, большая часть трафика органика. Вирусность рождается не из бюджета, а из понимания трендов и культуры, как появляются мемы и почему люди подхватывают один формат, а другой нет.

4. Центральная Азия как скрытая альфа. Ерзад делает ставку на инженеров из Казахстана и СНГ и прямо продаёт это инвесторам: сильная математика плюс трудовая этика. И да, до многих талантов просто ещё не добрались большие компании.

5. Нанимать надо не отличников, а хаслеров. Он смотрит на энергию и способность переживать адскую операционку. Типа человек, который параллельно тащил консалтинг и цветочный магазин, уже доказал, что не развалится, когда всё горит.

6. Все пиксели будут сгенерированы. Видео стало главным каналом. И мысль простая: в перспективе нейросети будут генерировать всё, что мы смотрим. Мы в ранней стадии, но скорость такая, что “через год уже будет нормальный ИИ-блокбастер” звучит не как фантазия, а как план.

7. Инфраструктура как суперсила. Пока кто-то поднимает десятки миллионов и сжигает их, они стартовали примерно с 8 млн и выживали за счет эффективности GPU. Быстро переезжать между дата-центрами, дешево тренировать, не утонуть в костах, это и есть конкурентное преимущество.

8. GitHub это новый социальный лифт. Диплом больше не пропуск. Код, проекты, звезды, репозитории работают как медиа: если ты реально сильный, тебя заметят без “правильного университета”.

9. “Черный ящик” это нормально. Не обязательно объяснить ИИ до винтика, чтобы он работал и создавал ценность. Мы мозг человека до конца не понимаем, но почему-то это никому не мешает строить цивилизацию.

10. Китайский подход к росту может быть умнее. Не обязательно постоянно расти любой ценой. Можно остановиться, перестроить процессы, стабилизироваться и только потом снова ускоряться. Это выглядит более устойчиво, чем вечный “вправо-вверх”. Наверное самый интересный инсайт.

И да, после этого интервью неприятно сидеть на месте. Думаешь, может нужно меньше спать.

БЫСТРЫЕ КАК ИИ НОВОСТИ

Что еще случилось с момента выхода крайнего выпуска

💰 Cerebras Systems (чипы Wafer-Scale Engine - гигантская “кремниевая пластина” для быстрого обучения/инференса) поднял $1B при оценке $23.1B. И что? У корпораций появляется рычаг: торговаться с облаками/NVIDIA за цену и сроки инференса, потому что есть жирная альтернатива с деньгами и поставками.

🎙️ ElevenLabs (генерация и клонирование голоса, дубляж) поднял $500M при оценке $11B. И что? “Голос” становится отдельной инфраструктурой для продуктов: саппорт, дубляж, персональные ассистенты - бюджеты уходят из студий в подписки и API.

📈 Google / Sundar Pichai: приложение Gemini - 750M+ MAU, Alphabet закладывает $175-185B капзатрат в 2026 (в основном дата-центры/AI). И что? Это план “залить AI в каждый продукт” - конкурировать будут не моделями, а доступом к аудитории и мощностям.

🧪 METR (организация, которая меряет “на сколько часов работы человека тянет агент”) оценила GPT-5.2 high: 50% time-horizon около 6.6 часа. И что? Можно отдавать агенту полу-дневные инженерные куски (дебаг, рефактор, интеграции) - и строить процессы “постановка задачи -> проверка результата”.

🏥 Lotus Health (AI-первичка: диагноз/рецепт/направление, заявляют лицензии в 50 штатах) поднял $35M Series A. И что? Появляется модель “медицина как софт”: 24/7 триаж и рецепты по цене почти ноль - страховщикам и клиникам придётся либо подключать, либо объяснять, почему у них дороже и медленнее.

🛒 Amazon раскатал Alexa+ по США: Prime - бесплатно, остальным $19.99/мес (есть ограниченный free tier). И что? Большая подписка (Prime) начинает “съедать” AI-ассистентов как бонус - мелким ассистентам сложнее брать деньги за базовые функции.

🎮 Roblox запустил 4D generation на базе Cube (их foundation model): из текста генерит интерактивныеобъекты (поведение/физика). И что? Контент в UGC-играх будет штамповаться быстрее, а ценность сместится в дизайн правил и экономику, а не в моделинг.

🔎 Perplexity прокачал Deep Research (Advanced), заявляет SOTA на внешних бенчмарках, доступно для Max (и/или Pro по раскатке). И что? “Ресёрч под задачу” превращается в продуктовый стандарт - в командах это убьёт часть ручного ресёрча и поменяет требования к аналитикам (проверка и постановка, а не сбор ссылок).

🧩 Perplexity Model Council: один запрос гоняется через 3 модели параллельно, потом сборка в единый ответ. И что? Это шаблон для корпоративных ассистентов: повышать надёжность через ансамбль, а не ждать “идеальную одну модель”.

🗣️ Mistral Voxtral Transcribe 2 (speech-to-text) - 13 языков, есть open-weights Realtime под Apache 2.0 для стриминга. И что? Речь можно тащить в приватный контур и на edge-устройства: колл-центры/встречи/саппорт без отправки аудио “в чужое облако”.

📱 Meta тестирует отдельное приложение Vibes (лента + создание AI-видео), раньше было внутри Meta AI. И что? Meta строит отдельный “AI-видео-ТикТок”, значит брендам придётся готовить пайплайн генерации и модерации под новую площадку.

BIPI AI - СООБЩЕСТВО!

Хочешь быстрее внедрять ИИ и меньше ошибаться - нужно окружение, где это делают каждый день.

BIPIAI - закрытый клуб фаундеров и топ-спецов.

Что внутри:

• разборы реальных бизнес-кейсов

• готовые пайплайны и шаблоны внедрения

• созвоны, где участники показывают, как у них устроено

• люди, которые помогают собрать решение под новую реальность

90+ участников, 15 стран.

На сегодня это все

Это был очень насыщенные и интересные 24 часа из мира AI и роботов, которые меняют нашу с вами жизнь.

До завтра!

Дмитрий Грин

P.S.

Чтобы помочь мне понять как вам этот дайджест. Пожалуйста нажмите на максимально релевантную кнопку.